Dans la clientèle des PME, il n’est pas rare de croiser des infrastructures vieillissantes. Ou plutôt, qui exploitent des technologies d’un autre temps. Et ceci, bien qu’elles aient été installées récemment. Par réflexe, par souci de rentabilité ou par retard technologique, les prestataires de ces entreprises ont fait des choix peu pérennes. Au détriment de celles-ci. Mais alors, comment identifier une informatique moderne ? C’est ce que nous allons voir.

Tout d’abord, commençons par éviter de tomber dans le fantasme. Il n’y a ni solution technologique ultime, ni informatique qui serait une panacée. Chaque entreprise voit sa solution IT sous le prisme de ses besoins. Loin de moi l’idée de vous orienter vers tel ou tel fournisseur qui serait un choix évident et inévitable. D’ailleurs, Steel Blue n’est pas revendeur de produits, mais fournisseur de ses propres solutions, dont les composants évoluent au fil du temps.

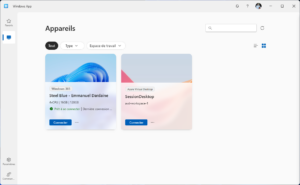

La preuve ? Notre produit Steel Workgroup est notre fer de lance. Il s’agit d’un service managé, regroupant des outils collaboratifs (messagerie d’entreprise, stockage et partage de fichiers, collaboration d’entreprise) et des services professionnels associés. Ces prestations couvrent le support, la maintenance, les mises à jour, la gestion des modifications, la documentation, le reporting mensuel. Si ce produit se base aujourd’hui sur Microsoft 365, il a longtemps exploité les services d’Amazon Web Services. Avant que ceux-ci ne deviennent moins compétitifs pour nos clients.

Les besoins, et rien d’autre

Non, l’objectif ici consiste plutôt à vous donner les clés pour identifier les choix à éviter. Toujours du point de vue d’une PME/TPE suisse, pour une taille oscillant entre 5 et 50 utilisateurs. La question du fournisseur technologique ou de l’éditeur importe peu en la matière. C’est le principe que nous cherchons à expliquer. Celui-ci peut être influencé en fonction de critères tels que l’évolution du marché, les changements technologiques, le budget ou encore la flexibilité, la fiabilité ou la simplicité.

Pour obtenir une vue d’ensemble assez complète, il convient de définir ce qu’une PME fait de son informatique. Et en quelque sorte, ses besoins. Pour une entreprise de petite taille, c’est assez simple : on parle de bureautique (emails et fichiers), et d’applications de base (métier et/ou support, regroupant devis, facturation, comptabilité). Autrement dit : il s’agit de stocker et partager des documents, d’échanger des messages et de faire tourner quelques programmes spécifiques.

Ces dix dernières années ont vu l’émergence des solutions SaaS (Software-as-a-Service), c’est-à-dire des programmes hébergés en dehors des murs, centralisés et mutualisés, et souscrits « à la demande » via des abonnements annuels ou mensuels. Ceci a particulièrement affecté les applications support de base, au premier rang desquelles se trouvent la comptabilité et la paie, voire la facturation. Il est vrai qu’acquérir un serveur (et le maintenir) pour faire tourner WinBiz et les faibles volumes de données dont il a besoin n’a plus vraiment de sens.

Applications et informatique moderne

Pour les applications métier, c’est une autre histoire. Comme elles sont bien plus spécifiques, leur marché est plus restreint. Ce qui n’incite pas les hébergeurs ou les éditeurs à proposer une solution externalisée, en tout cas à des tarifs raisonnables. Dans ce cas précis, disposer de son propre serveur peut faire du sens. Mais il y a serveur et serveur. C’est le critère budgétaire qui va prendre le pas ici. Car acheter une machine pour la mettre dans ses bureaux et la dorloter ne serait pas raisonnable.

Pourquoi donc ? Les infrastructures Cloud sont devenues hyper-matures. Alors que de votre côté, vous vous échinerez à héberger une machine dans vos locaux, à assurer son alimentation et sa protection électriques, à prendre soin de la température de l’air. Et surtout, à la maintenir en état de marche. Entre achat, mise en service et maintien en conditions opérationnelles, les coûts de possession d’un serveur ne sont pas négligeables. Et surtout, bien plus élevés qu’une machine virtuelle louée via un prestataire d’infogérance. On parle ici de plusieurs dizaines de milliers de francs sur la période d’amortissement de ce matériel.

Côté bureautique, c’est un peu le même constat. L’hébergement sur site de documents et d’emails n’est plus vraiment d’actualité. Et pourtant, il n’est pas rare non plus de croiser des serveurs de fichiers ou Exchange sur des serveurs surpuissants. Maintenir cette machinerie en état est une peine quotidienne coûteuse, qui génère insatisfaction et frustration. Tout en creusant le budget des PME qui s’y accrochent. Et je ne parle pas seulement du matériel, mais également de la configuration logicielle et de la sécurisation. Un serveur de messagerie requiert une exposition à Internet dont les pirates se délectent, au gré d’attaques et d’exploitation de failles de sécurité.

Les fichiers, le pilier de l’IT des PME

Quant aux fichiers, le COVID a mis en évidence la difficulté d’y accéder à distance lorsqu’ils se trouvent sur des disques sur site. Le VPN peut contrebalancer cela, mais c’est évidemment ajouter une couche de service, qu’il faut, là encore, entretenir et sécuriser. Et ceci sans compter avec les difficultés d’accès depuis la maison. Les solutions de stockage et d’hébergement Cloud se sont progressivement imposées, car plus flexibles, plus sécurisées, et plus simples à mettre en œuvre pour des PME qui doivent, de facto, externaliser la gestion de leur informatique par manque de compétences et de connaissances.

Au premier rang de celles-ci se trouve Microsoft 365, qui a le bon goût d’intégrer tous les outils dans une seule suite. Mais d’autre acteurs, tels que Dropbox pour les fichiers ou Slack pour la collaboration, ont aussi fait leur trou. Toutes sont accessibles depuis une simple connexion Internet, si bien que le bureau n’est plus un endroit privilégié pour les exploiter, mais un point d’accès aux données comme un autre. Tout en apportant un niveau de sécurité inaccessible pour une PME avec des ressources hébergées en son sein. Cryptage au repos comme en transit, double authentification, redondance locale et géographique : autant de propriétés qui viennent de facto avec les outils d’une informatique moderne.

Ces tendances sont celles du moment. Et peut-être pas celles de demain. Car l’évolution permanente de l’informatique rebat les cartes des choix possibles à intervalles réguliers. La modernité n’est donc qu’un concept, qui évolue au fil du temps et qui doit être remis en question en permanence. Ce qui implique de devoir se maintenir à niveau. Reste à savoir dans quel état se trouve votre informatique et si elle coche déjà quelques critères de modernité actuels. Histoire de garder une longueur d’avance en termes de flexibilité, de contrôle des budgets et de mobilité.

Emmanuel Dardaine

Et si on inspectait votre informatique pour savoir si elle coche les cases de la modernité ?